di Antonio Delogu, già ordinario di Filosofia morale, Università di Sassari

Brevi note su poesia, scienza e intelligenza artificiale © 2024 by Antonio Delogu is licensed under CC BY-SA 4.0 © 2024 by Maria Galdi is licensed under CC BY-SA 4.0

Abstract

Il poeta porta a evidenza, in virtù dell’immaginazione, le verità dello strato precategoriale del mondo vissuto. Anche lo scienziato si affida all’immaginazione nella scoperta delle verità del mondo oggetto. L’IA non può creare poesia né conoscenze radicalmente innovative nel campo scientifico: accresce il già dato (siti WEB, libri, saggi, ecc.) ma non in discontinuità col già conosciuto.

Keyword: immaginazione, creatività, mondo vissuto, precategoriale

The poet brings to light, through the power of imagination, the truths of the pre-categorial layer of the lived world. Similarly, the scientist relies on imagination to discover the truths of the objective world. AI cannot create poetry or radically innovative knowledge in the scientific field: it amplifies what already exists (websites, books, essays, etc.) but does not break away from what is already known.

Keywords: imagination, creativity, lived world, pre-categorical

Introduzione e stato dell’arte

Poesia e scienza sono, a prima vista, due percorsi conoscitivi lontani per modalità di approccio alla verità. Tuttavia, a ben vedere come stanno veramente le cose, per importanti aspetti possono considerarsi assai vicini. Guardiamo, pertanto, alla poesia e alla scienza per ciò che li accomuna per metodo e fine.

Il poeta descrive l’essenza delle cose del mondo della vita o mondo vissuto nel senso in cui ne parla Husserl, soprattutto nel suo ultimo lavoro La crisi delle scienze europee e la fenomenologia trascendentale. Essenza nel significato non di fondamento ultimo o principio primo della realtà (di cui la metafisica sostanzialistica parla dalle origini del pensiero occidentale sino ai giorni nostri ) ma nel significato di carattere permanente, perenne, universale delle reali o possibili umane esperienze.

La poesia tende a portare a evidenza lo strato originario, autentico duraturo del mondo della vita, occultato da pervasive abitudini, da “pre-giudizi” ideologici, da precostituite concezioni del mondo[1].

Anche al poeta, come al filosofo che ha percorso i sentieri della metafisica ( con risultati contrastati e contrastanti ) è precluso il possesso conoscitivo del fondamento ultimo della realtà. A riguardo, non l’evidenza ma l’approssimazione è nelle sue possibilità conoscitive e, perciò, raramente si avventura sui percorsi della metafisica essenzialistica, consapevole del fatto che il mistero è al fondo del mondo della vita oltre che del mondo naturale.

Il poeta tocca gli strati originari delle umane esperienze in virtù di fine sensibilità, d’intuizione perspicace, di appassionata sapienza, d’ingenuità dello sguardo, di maturità di giudizio.

La sua intuitiva attenzione vive di disciplina intellettuale, fervore sapienziale, interiore purificazione dal conformistico, abitudinario modo di vedere le cose.

La poesia è tensione a verità radicali, espressione di straordinaria comprensione dell’essenziale insito nell’esistenziale, dell’eterno incarnato nel contingente, del meta-fisico cioè di ciò che sta oltre, al di là della realtà biofisica; per dirla in breve, del senso (l’invisibile) dell’oggetto (il visibile).

Il poeta può introdursi “ in golfi e abissi inesplorati, in terre senza tempo e senza luogo” poiché nel suo cammino “ il mondo confina con l’inesauribile, l’insondabile”[2].

La poesia è rapporto intenso e intensificato con l’esperienza vissuta: illumina il senso originario tanto delle cose umili quanto di quelle elevate, riscoprendone l’inesauribile ricchezza nella cui contingenza alberga ciò che di esse è perenne, universale o universalizzabile.

Il poeta è, quindi, in rapporto diretto con l’essenza, il “segreto” delle cose del mondo vissuto in virtù dell’esercizio dell’husserliana epoché che consente di essere dentro e, al contempo, al di sopra delle umane esistenze.

Nel suo cammino conoscitivo evita i preamboli metodologici, le divagazioni argomentative, le lungaggini o pause esplicative, le afflizioni ideologiche, il peso dei “pre-giudizi”: va direttamente alle cose, animato da originaria innocenza, da fuoco sacrale che ridona splendore alle parole e alle cose. Si affida alla sensibilità, all’intuizione, all’immaginazione così che può vedere ciò che gli altri non vedono: la profondità e la preziosità del mondo della vita.

L’autenticità della parola, l’incondizionatezza del pensiero sono essenziali alla poesia, che è tensione alla verità portata a evidenza dall’inquietudine, che “perlustra e scruta”, per dirla con un famoso verso di Caproni, l’intreccio tra paesaggio interiore e paesaggio esteriore, tra tempo e perennità, orizzontalità e verticalità.

La poesia è il cammino descrittivo che conduce al precategoriale intreccio tra mondo vissuto e mondo oggetto. Non a caso è fioritura di metafore che consentono il contatto con la sacralità delle cose, con lo strato esperienziale che ne trascende la mera fisicità. La metafora, Borges ha detto, è l’anima, ciò che dona anima alla parola.

La poesia scopre l’universalità e la perennità nelle contingenti sensazioni, nei fuggevoli stati d’animo in virtù di un vigore conoscitivo che trascende il logoramento esistenziale motivato dalla vita abitudinaria. Perciò oltrepassa il proprio tempo, come testimonia il fascino di ciò che è veramente poesia: il suo essere dono per il poeta e per il lettore di rinnovata freschezza d’animo.

La poesia è invenzione di un nuovo linguaggio perché esige la scoperta dell’autentico valore semantico della parola, e resta vera poesia quando non cade nell’oscurità degli artifici sperimentalistici in cui, a dire il vero, la poesia muore.

I grandi poeti sono tanto profondi quanto capaci di esemplare chiarezza. Non a caso il contadino e il pastore possono recitare l’Odissea e la Divina Commedia; non a caso l’adolescente legge Petrarca e Leopardi con appassionata, empatica intelligenza e, per stare al nostro tempo, Ungaretti e Montale, Walt Whitman e Borges, Machado e Garcia Lorca.

La vera poesia si affida all’universale comprensibilità perché esige tanto l’essere colta quanto l’essere popolare.

Il poeta esplora lo strato preriflessivo, precategoriale del mondo della vita abbandonando il passo della prosa con l’esercizio della esemplare ( difficile da praticare ) semplicità espressiva.

Il poeta può descrivere, perciò, con fedeltà al dato esperienziale, la pienezza di senso del candore di un gesto, della grazia di un sorriso, della dolcezza di uno sguardo, della tenerezza di un sentimento, della pesantezza d’anima; può portare a evidenza il senso universalmente esperibile dell’incolore quotidianità, delle insensate abitudini, del grigiore della noia, dell’angosciante oscurità della disperazione, della crepuscolare tristezza, della malinconica o nostalgica peregrinatio nel tempo o della luminosa freschezza dell’innamoramento; può cogliere, insomma, lo strato di senso nascosto nelle pieghe delle abitudinarie, esistenziali esperienze; può donarci, con meravigliosa e meravigliata fedeltà a come stanno veramente le cose, la bellezza, la ricchezza, la complessità e la problematicità del mondo per noi.

L’acqua della scienza è esattamente descritta e spiegata dalla formula H2O. L’acqua della poesia è altrettanto esattamente quanto diversamente descritta nel Cantico delle creature di S. Francesco ( “Sor’Acqua/la quale è multo utile et humile et pretiosa et casta”) e nelle mirabili petrarchesche Chiare, fresche e dolci acque.

I poeti ci donano molte verità sugli smarrimenti esistenziali, sul torpore dell’anima, sulla gratificante spiritualità, perché la poesia è, in definitiva, atto di libertà dello spirito, del cuore e della mente; atto che nasce dalla vocazione a fare esperienza di interiore rinascita, di rinnovamento del proprio modo d’essere al mondo, di un nuovo sguardo sulle cose che ci riguardano.

Il poeta ci conduce alla scoperta di un nuovo mondo, di esistenziali paesaggi di cui, altrimenti, poco o nulla potremmo sapere. Perciò crea in noi stupore, meraviglia, lo stato d’animo per il quale il poeta Machado ha detto che la poesia “ è un profondo palpitare dello spirito”. Troviamo la verità che ci dona il poeta spagnolo in un magnifico verso di Borges: “La poesia è un’Itaca di verde eternità”.

La grande poesia non è soltanto esercizio di raffinatezza formale, di esteriore brillantezza del verso ma anche, per essenziale vocazione, ricerca della profondità di senso del mondo della vita.

Ciò manca negli pseudo poeti che difettano di meditato esercizio del pensiero e del sentimento.

Nella poesia frutto di superficialità e di improvvisazione non troviamo la chiarezza e la semplicità per le quali, ha detto Robert Louis Stevenson, le parole escono dal loro uso quotidiano per trasformarsi in magiche modalità espressive. Il fatto è che, come dice Borges, sappiamo cosa è la poesia ma non siamo in grado di definirla come ci accade anche per il tempo o l’amore.

La stessa poesia d’occasione, che descrive credenze, sentimenti, vissuti propri di ben precisate circostanze, si eleva al disopra del tempo in cui nasce e di cui parla per situarsi al livello del poema, dell’inno, dell’epica, della lirica, dell’elegia.[3] La poesia che resta imprigionata nella circostanza di cui parla scade a canzone. Ma la canzone non è poesia come accade di leggere in antologie scolastiche dove i cantautori si propongono come poeti: si è giunti al punto che al cantautore Bob Dylan è stato dato il premio Nobel (negato all’impareggiabile Borges).

Ragionamento e poesia

Dove c’è ragionamento, afferma Benedetto Croce, non c’è poesia. Il filosofo neoidealista parla, evidentemente, del ragionamento che si svolge per deduzione, per logica concatenazione di concetti.

Vi è, però, anche il ragionamento poetico che, coniugando passione e ragione, intuizione, immaginazione, riflessione e meditazione è vera e propria esperienza del venire al mondo degli esseri e delle cose, cioè fedele descrizione del senso originario del mondo della vita.

Nella poesia accade il miracolo del respiro metafisico capace di restituirci l’aurorale splendore del nostro originario essere al mondo tramite il sapiente, dialettico intreccio di pensiero riflessivo e esperienza preriflessiva.

La poesia che ci parla della dimensione precategoriale delle esistenziali esperienze non per dottrina o sistema ma per straordinaria descrizione /narrazione si dà come vera e propria riverenza verso tutte le cose.

L’approdo poetico è l’ouverture del mondo vissuto, non come tempo mitico o remoto, come Età dell’Oro, dell’Eden perduto, ma come sorgiva esperienza dell’essenza valoriale del mondo della vita. Il poeta che ci porta entro le cose stesse, entro il ritmo perenne del divenire delle umane esperienze, a contatto con lo strato ontologico del nostro essere al mondo, ci dice che la nostra inerenza è, al contempo, trascendenza rispetto al nostro essere al mondo vissuto come intreccio di soggetto e oggetto, di coscienza e natura: “Ho sentito, in una foresta”, ha detto, con eleganza poetica, il pittore André Marchant, “che non ero io a guardare la foresta, erano gli alberi che mi guardavano, che mi parlavano”. Il paesaggio si pensa in me, diceva poeticamente Cézanne[4].

Straordinario è il fatto che il testo poetico sia oltre che dell’autore anche del lettore: la sua vita continua nell’animo e nella mente di chi legge. L’esperienza poetica, in effetti, vive nella unicità del poeta quanto nella molteplicità dei lettori, come tensione alla atemporalità, alla verticalità, abbandono del già detto, del già fatto, del già visto: “In nessun dove”, ha scritto Rainer Maria RilKe, “sarà mondo/ se non dentro di noi”.

Può dirsi anche che la poesia sia, in qualche misura, esperienza di preghiera se la preghiera è l’uscita dalla vacua quotidianità, anelito all’insondabile, al mistero, esperienza di religiosità che coglie la sacralità di ogni cosa. La poesia è la liturgia dell’anima che vive il palpito dell’eterno nel respiro del contingente.

La verità è , come Pessoa ci ha detto, che “la poesia esprime l’anima intera” che la meraviglia, lo stupore liberano del velo della insensata quotidianità, manifestandoci la realtà come se, suggerisce Borges, “tutto accada per la prima volta anche per il lettore”. La poesia è come lo sbocciare della rosa che dona, per incanto, profumo ( senso ) al mondo.

Cosa dire del modo di procedere della ricerca scientifica?

Il desiderio di conoscenza della Natura sollecita lo scienziato all’esercizio della descrizione/ spiegazione dei dati empirici. La lettura del mondo biofisico è, per lui, questione di visione prima che di tecnica. Lo scienziato segue indizi, tracce, si sofferma su dati apparentemente insignificanti da cui trae la verità del fenomeno astraendone la causa o legge che lo pone in essere e lo determina. Newton osserva la caduta della mela che nulla dice allo sguardo della superficiale quotidianità, ma da quella fuggevole caduta, andando oltre ciò che la vista gli offre, induce la legge fondamentale della gravitazione.

La scienza scopre le leggi che stanno dietro l’apparenza dei fenomeni affidandosi sia all’empiria che alla razionalità orientate alla conoscenza del mondo pensato, del mondo oggetto.

Il sapere scientifico giunge alla conoscenza delle cause o leggi dei fenomeni naturali per rettificazioni e purificazioni progressive, cioè, dice Bachelard, uscendo dalle false evidenze[5].

La ricerca scientifica è radicale rinnovamento del sapere: le rotture epistemologiche (come la teoria della relatività e la teoria quantistica) impongono l’abbandono di teorie scientifiche diventate dogmi, credenze ideologiche[6].

Thomas Kuhn distingue tra scienza ordinaria e scienza straordinaria in quanto scienza che fa emergere nuovi paradigmi che sono alla base delle rivoluzioni scientifiche. Ma il superamento dei non più praticabili paradigmi può avvenire soltanto in virtù dell’immaginazione, di una esperienza intellettuale veramente creativa.

Il lavoro dello scienziato nasce non dalla fredda razionalità, dalla pratica di rigidi protocolli metodologici ma dall’immaginazione. Il metodo, nella ricerca scientifica, non precede ma segue l’atto intuitivo-creativo.

La scienza, quando esplora i suoi campi d’indagine (matematica, geometrie, fisica, astrofisica, geofisica, biologia, genetica) scopre “mondi” lontani da quelli della realtà quotidiana, con lo spirito di avventura cioè con l’immaginazione, che, dice Giacomo Leopardi, è “la sorgente della ragione: “L’immaginazione fa i grandi scopritori di verità: da una stessa sorgente, diversamente applicata, vennero i poemi di Omero e Dante e i Principii matematici della filosofia naturale di Newton”[7].

Einstein, in una famosa lettera a Maurice Solovine del 1956, scrive che la comprensibilità del mondo è come un miracolo, un eterno mistero al quale solo l’immaginazione ci consente di accostarci.

Simon Weil ha scritto che la scienza per raggiungere il Bene “si deve allontanare dalle cose del mondo”[8]. Quando l’astrofisico indaga sull’origine e sulla fine dell’universo, sulla struttura profonda del Cosmo, si allontana anni luce dal mondo della sua quotidianità.

Perciò lo scienziato tramite l’osservazione del fenomeno particolare può portare a evidenza “verità generali grandi e importanti”[9].

La scienza

Il termine scienza, afferma Jonas, ha nel campo linguistico tedesco un’accezione più vasta rispetto a quella che assume nell’area anglosassone e abbraccia in sé anche le scienze dello spirito e della cultura e, diremmo, include perciò anche la poesia[10]. In questo senso può dirsi che scienza e poesia sono, in qualche modo o misura, germogli diversi di un’unica radice.

Heisenberg ci dice che i poeti muovono spesso obiezioni agli scienziati che traducono i loro percorsi conoscitivi in rigidi schemi logici[11]. Gli scienziati si affidano prima che agli schemi logici e alle procedure metodologiche all’immaginazione, i poeti elevano il linguaggio argomentativo e quello della quotidianità a novità espressiva e veritativa.

La verità delle leggi del mondo naturale, su cui verte il lavoro scientifico, è pari all’essenzialità di senso del mondo vissuto su cui verte lo sguardo poetico. Anche lo scienziato, a volte, ricorre come il poeta alla metafora. Nell’uno e nell’altro agisce, potremmo dire, una forza visionaria. La ricerca scientifica, come la scrittura poetica, è esperienza di passione, emozione oltre che d’ordine logico, di rigore d’argomentazione razionale.

Si può ragionare poeticamente e poetare razionalmente: scienziati e poeti, entrano nei rispettivi, distinti campi d’indagine, in qualche modo e misura, non con la fredda ragione ma con la calda immaginazione, poiché l’esattezza del mondo scientifico si dà come bellezza, come la bellezza del mondo poetico si dà come esattezza.

Lo scienziato, come il poeta, ricerca e scopre la bellezza, lo splendore dell’ordine che governa il mondo. Anche la sua visione della natura genera emozioni, stupore, meraviglia. Anche la sua avventura conoscitiva è attivata da sensibilità, da fantasia, dall’inquietudine del “non sapere”, dall’insofferenza per l’ignoranza, dall’errore che esige verità, dall’approssimazione che esige disciplina.

Vigore creativo e impegno riflessivo motivano il lavoro intellettuale del poeta (volto al mondo infinitamente ricco delle umane esperienze, delle profondità e delle altitudini spirituali) e quello dello scienziato [volto al mondo ( esemplificando )] delle particelle subatomiche, della relatività dello spazio-tempo, delle relazioni della meccanica quantistica, dell’immensità delle galassie, del microcosmo “bio-fisico” ).

Lo scienziato e il poeta, con diverse modalità, viaggiano nei leopardiani “sterminati spazi” e “sovrumani silenzi”, fanno esperienza di produttiva contemplazione che, ci dice Dante Alighieri, è “perfezione della nostra anima”.

Lo scienziato, come il poeta, fa esperienza di uno sguardo radicalmente nuovo sul mondo che esplora: Einstein ha cambiato il modo con il quale guardiamo all’universo: gli oggetti, la luce, lo spazio, il tempo, la massa, l’energia.

L’avventura scientifica e quella poetica sono esperienze d’interiore raccoglimento creativo, di visione straordinaria, di estraneazione dal quotidiano vivere e sentire, di sguardo puro per la Verità, d’insopprimibile desiderio di conoscenza che attiva l’entusiasmo per l’avventura conoscitiva, l’amore per la disinteressata curiosità intellettuale.

Nell’esperienza scientifica e in quella poetica le persone sono animate da spirito di libertà, di responsabilità, di onestà intellettuale e morale, in definitiva, di saggezza, in cui non vi è spazio per scopi o sentimenti egoistici.

Tra scienziati, come tra poeti, non vi è conflitto poiché il loro impegno intellettuale è mirato all’universalità del sapere.

L’esperienza scientifica e quella poetica sono anche nuove esperienze di sé oltre che del mondo, che vengono a evidenza nel silenzio, nella lontananza dai rumori, dagli umori, dai malumori; nell’uscita dall’irrequietudine, nell’attenzione che si dà nell’atto creativo di scoperte di nuovi mondi.

Lo scienziato e il poeta si affrancano dalla contingenza, dalla passività vivendo una sorta di beatitudine spirituale che si trasforma in meraviglia, stupore per la scoperta di un nuovo mondo: mondo vissuto per il poeta, mondo oggetto per lo scienziato.

Il poeta e lo scienziato si affidano all’immaginazione, che è la dimensione conoscitiva propria dell’esperienza creativa. Senza immaginazione non si prova il volo poetico, non si formulano ipotesi nella ricerca scientifica[12].

L’esperienza razionale ed emotiva del poeta si ripete nel lettore, che se ne sente personalmente coinvolto. Il lettore con la sua immaginazione si immerge nel mondo del poeta, lo ricrea, lo rinnova, lo arricchisce. L’esperienza intellettuale ed emotiva dello scienziato è, invece, esclusivamente personale o condivisa dal e nel gruppo di ricerca. Il lettore non può rifarne il cammino neppure con l’immaginazione: ne conosce soltanto il risultato.

Il lavoro del poeta sfiora il mistero del mondo della vita, il lavoro dello scienziato si confronta con i problemi posti dalla necessità di conoscere il mondo naturale.

Perciò è importante che gli scienziati frequentino il mondo dei poeti perché ciò può intellettualmente arricchirli. Altrettanto importante è che i poeti frequentino il mondo degli scienziati poiché il vissuto di cui danno comprensione ha la sua radice nella realtà di cui gli scienziati danno spiegazione. Il poeta che ignora il cammino della scienza rischia la fantasticheria, lo scienziato che ignora i sentieri della poesia rischia l’aridità del sentire e del pensare.

L’auspicio è che anche gli scienziati sentano il desiderio di avvicinarsi al mondo dell’invenzione poetica e che i poeti sentano l’esigenza guardare al mirabile mondo degli scienziati. Forse è questo il significato di ciò che ha detto Novalis: “La forma compiuta delle scienze deve essere poetica”.

Il poeta e lo scienziato, incrociando e intrecciando le loro esperienze creative convergono verso il senso e il fine autentici della loro fatica conoscitiva, verso la Verità che abita nella coscienza di ciascun individuo: il rispetto della Natura, la dignità di ogni individuo, la sacralità di ogni umana esistenza. Tutto ciò non può non portare a evidenza anche le differenze tra i due percorsi conoscitivi. Nella poesia non ci sono progressi né invecchiamento, nella scienza il progresso è essenziale perché le scoperte scientifiche esigono l’abbandono delle acquisite certezze.

L’intelligenza artificiale può creare poesia, può creare scoperte scientifiche?

L’IA è la capacità di trovare soluzioni a un’infinità di problemi utilizzando i database senza i quali non potrebbe giungere ad alcun risultato. Il suo percorso conoscitivo muove dal già dato per avviare e svolgere un ben precisato (vedi Popper) metodo di ricerca. Ben diverso è quello del poeta orientato verso le verità profonde, le ragioni essenziali del mondo della vita che possono darsi ad evidenza nel ritmo, nella musicalità, nella bellezza, nella originalità irripetibile del momento sorgivo della sua creatività. L’IA, il robot umanoide è dato biofisico, non corporeità cioè corpo vissuto, esistenziale esperienza di sentimenti, affetti, di dubbio, di scelta, di desiderio.

L’IA non è e non ha il “dentro di noi” in cui alberga anche il silenzio del raccoglimento da cui può nascere l’innovativo, creativo linguaggio poetico.

L’intelligenza poetica, non l’IA, comprende il linguaggio del cielo (limpido, oscuro, tempestoso, sereno), il linguaggio del mare (calmo, impetuoso), del tramonto (triste, nostalgico, amoroso, sognante), dell’alba (fresca, vigorosa), del paesaggio; il silenzio della umana fragilità, la sofferenza delle ferite dell’anima.

Il poeta prova cioè vive intensamente l’esperienza creativa che, scrive il poeta cileno Vicente Huidabro, è “come una chiave che apre mille porte”.

Il mondo di cui può parlare l’IA non è il mondo delle allegorie, delle metafore, delle immagini che nella scrittura poetica, vero e proprio stato di grazia; è esperienza di splendore e purezza d’anima, d’inquietudine metafisica. Il mondo dell’IA proviene dal già dato (i database), la poesia nasce dalla novità del momento creativo.

Se si parla di IA con riferimento a ChatGPT ( trasformatore generativo “pre-addestrato”: altri sistemi di IA, meno sofisticati, sono Siri e Alexa ) è necessario tener in evidenza che siamo agli inizi di una tecnologia di cui non è possibile immaginare gli sviluppi come al tempo del volo dei fratelli Wright non era possibile immaginare gli attuali traguardi dell’astronautica; o, al tempo di Antonio Meucci immaginare il salto di qualità dalla invenzione del telefono agli attuali cellulari.

Il sistema ChatGPT consente oggi di rispondere a un’infinità di domande, di comporre articoli e saggi su qualsiasi argomento in brevissimo tempo, di comporre canzoni, di tradurre un testo in molte lingue, di riassumerlo: tutto ciò utilizzando i database.

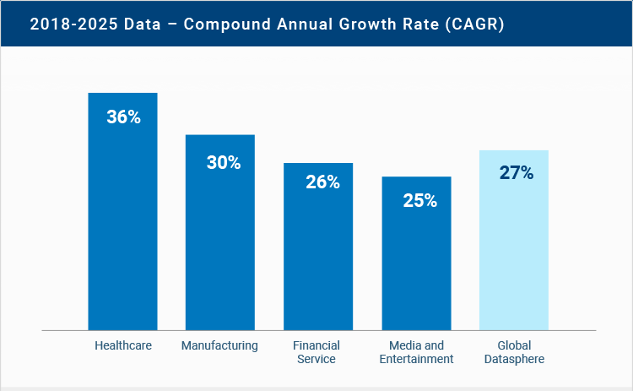

In effetti, ChatGPT viene addestrato sui dati tratti da libri, articoli, siti web: ciò consente l’aggiornamento e l’accrescimento continuo delle conoscenze.

Il problema che ci si pone, però, è se l’IA può creare poesia, fare scoperte scientifiche che segnino un vero salto qualitativo rispetto alle conoscenze acquisite, come può dirsi della relatività e della meccanica quantistica rispetto al meccanicismo newtoniano.

Riguardo alla poesia vi è da dire che essa nasce dal mondo vissuto così che vi sono coinvolte sensibilità, intenzione, emozione, immaginazione. La poesia, quindi, è esperienza di comprensione delle molteplici modalità in cui si dà il mondo della vita, non di spiegazione di problemi del mondo oggetto: la soggettività, la corporeità come corpo vissuto ne sono la fonte, la trama.

L’IA è razionalità pragmatica, la poesia è ragione contemplativa, espressione di una soggettività che è non un fatto o un dato ma un farsi nella comprensione di sé, del senso del suo essere soggettività esistenzialmente esperienziale.

L’IA non è coscienza di sé, del senso di ciò che fa, del valore semantico del linguaggio. Non può sapere la differenza tra “gli elettricisti stanno lavorando” e le “lavatrici stanno lavorando”; tra “il custode aprì la porta” e il vento soffiò nella stanza”[13]. Altrettanto può dirsi riguardo alle “ ferite dell’anima e ferite del corpo”, di un’anima che ondeggia e del mare che ondeggia.

Nel campo dell’IA il rapporto è non tra soggetto e oggetto ma tra oggetto e oggetto; perciò, non vi può germogliare il senso delle esistenziali esperienze: il senso della paura, del timore, dell’attesa, della speranza, del pentimento, del rimorso, del ravvedimento, della gelosia, delle infinite sfumature dei sentimenti.

L’IA non può fare esperienza di ragionevolezza, di saggezza, della gratificante solitudine né della deprimente solitudine; non può comprendere, chiusa nella razionalità logica degli algoritmi, il valore della spirituale energia, della forza morale perché l’una e l’altra trascendono la dimensione biofisica.

L’intelligenza umana è razionalità e immaginazione, l’IA è memoria (molto più della intelligenza umana) e calcolo, ma non immaginazione né volontà né desiderio di immaginare.

Nella poesia c’è l’anima del poeta con le sue luci, le sue ombre, le sue penombre, le sue estasi, le sue beatitudini, le sue nevrosi, la sua interiore stanchezza.

La poesia è, per eccellenza, esperienza di autoriflessione, di autocoscienza inclusiva del mondo vissuto, relazionale, intersoggettivo.

L’IA è del mondo di cui parlano il fisicalismo, il materialismo, il meccanicismo ai quali non è riducibile l’anima, l’esistenziale interiorità in cui nasce il senso del mondo vissuto.

La poesia esige il passo della comprensione, della sensibilità, impossibile per l’IA.

L’IA non aspira alla virtuosità, al perfezionamento morale: non è esperienza di benevolenza, compassione, biasimo, ambizione, tenerezza, dei sentimenti, insomma, che possono costituire la trama del vissuto poetico.

L’IA non può essere madre, padre, figlio, amico, non è né può essere esperienza in prima persona: non è soggettività in cui originariamente nasce il desiderio di conoscenza, di comprensione di ciò che si è e di ciò che si vuole essere per il fatto, di tutta evidenza, che è oggetto posto in essere dal soggetto umano.

Si può dire che la poesia è l’espressione della soggettività al più alto grado (come la filosofia e la scienza) che sia l’espressione, la manifestazione dell’anima di cui secoli di materialismo, di determinismo non hanno cancellato la traccia[14]; altrettanto non può dirsi della IA.

Così stanno le cose. Del futuro, soprattutto di quello remoto, non è possibile dire qualcosa di plausibile, tantomeno di certo. Lo scrittore di fantascienza K. Stanley Robinson, nel suo recente racconto Aurora (Ubiliber, editrice dell’Unione Buddhista italiana, 2015) parla del viaggio di una gigantesca astronave che nel ventiseiesimo secolo porta duemila esseri umani verso il sistema Tau Ceti. Il viaggio dura duecento anni, così che nessuno degli umani partiti dalla Terra concluderanno il viaggio interstellare: alla conclusione del viaggio arriveranno forse i figli, certamente i nipoti e i pronipoti. L’IA Nave (che guida il viaggio cosmico) è capace di acquisire coscienza, emozione, senso del dovere, senso di fedeltà allo scopo per il quale gestisce l’astronave Aurora.

Di questa IA può parlare lo scrittore di fantascienza, non il filosofo né lo scienziato: siamo nel mondo del transumanesimo, del superamento dell’umano, della fusione tra intelligenza umana e intelligenza artificiale, dell’umanoide robotico.

Conclusioni

Cosa ne sarà, in questo nuovo mondo, della poesia? Ci sarà l’umanoide poeta? Anche questo è possibile, ma resta da vedere di quale immaginazione, di quale fantasia, di quale creatività, di quale contatto con la vita reale sarà capace la robotica IA.

Il mito di Pandora ( tra i più conosciuti della mitologia greca ) racconta che il dio Vulcano fabbricò una donna bellissima, Pandora appunto. Ciascuno degli dèi fece un dono a Pandora. Zeus le donò un vaso chiuso dicendole di non aprirlo.

La bellissima donna, però, disubbidì a Giove: aprì il vaso da cui uscirono tutti i mali del mondo: malattia, morte, vecchiaia, miseria, pazzia, violenza. Ma, dal fondo del vaso, uscì anche la speranza. Il mito di Pandora, raccontato da Esiodo nella Teogonia e nelle Opere e i giorni, può dirci qualcosa riguardo all’IA. L’umanoide, l’essere transumano fabbricato dalla tecnologia, può portare sciagure ma anche la speranza di un mondo migliore: su ciò che accadrà nel lontano futuro, come quello del XXVI secolo, il filosofo, il poeta, lo scienziato non possono dirci qualcosa di credibile: quali saperi ci saranno? l’umanoide robotico sarà intelligenza creativa anche in virtù del provare emozioni, meraviglia, speranza, sentimenti umani, insomma? sarà capace del creativo linguaggio poetico discontinuo rispetto al linguaggio comune e, perciò, capace di entrare nel labirinto degli infiniti significati del mondo della vita? sarà capace di pensiero veramente alternativo rispetto al modo comune di vedere le cose, di comprendere il senso della realtà? L’IA sarà autocoscienza, capacità di autocritica, energia intellettuale di autoformazione? sarà un fatto o un farsi? potrà fare esperienza del sonno, del sogno, del passaggio dal sonno alla veglia? l’IA sarà semplice oggetto biotecnologico o qualcosa di qualitativamente diverso come la mente, un essere che non esiste in sé, non è a se stante, ma si dà a conoscere nell’interazione col mondo in cui si trova inserito? sarà capace soltanto di pensiero calcolante o anche di pensiero immaginativo come quello del poeta e dello scienziato? Il futuro remoto è mistero, enigma, segreto che oggi non è possibile svelare.

[1] La bibliografia su che cos’è la poesia è, ovviamente, assai ampia. Indichiamo, qui, alcuni saggi per la loro vicinanza, sotto qualche aspetto, al percorso qui proposto: Mazzarella, Eugenio. “Lirica e poesia.” Bollettino Filosofico, December 12, 2017, Vol 32 (2017): Poesia e filosofia a confronto. A partire dal moderno. doi: 10.6093/1593-7178/5348; Mazzarella, 2007. Lirica e poesia. Brescia: Morcelliana; Boitani, Piero, 2001. Verso l’incanto: lezioni sulla poesia. Bari: Laterza; Paz, Octavio, 2023. L’altra voce. Poesia e fine secolo. Milano: Mimesis; Rondoni, Davide, 2008. Il fuoco della poesia. In viaggio nelle questioni di oggi. Milano: Rizzoli; Distaso, Leonardo V. “L’incantesimo della mimesis: poesia e filosofia tra essere stato e poter essere.” Bollettino Filosofico, December 12, 2017, Vol 32 (2017): Poesia e filosofia a confronto. A partire dal moderno. doi: 10.6093/1593-7178/5345; Bisutti, Donatella, 2016. La poesia salva la vita. Capire noi stessi e il mondo attraverso le parole. Milano: Feltrinelli.

[2] Mattesini, Francesco, Giuseppe Langella (cur.) ed Enrico Elli (cur.), Prefazione, 17. 2004. In Il Canto Strozzato. Novara: Interlinea Edizioni.

[3] Caillois, Roger. 1958. Les Jeux et Les Hommes : (Les Masque et Le Vertige), 131-132. Paris: Gallimard.

[4] Su questo aspetto del rapporto soggetto-mondo vedere il celebre saggio di Merleau-Ponty, Maurice. 1962. Il dubbio di Cézanne, 27-44. In Senso e non senso. Milano: Il Saggiatore.

[5] Vedere: Bachelard, Gaston. 1998. La filosofia del non – Saggio di una filosofia del nuovo spirito scientifico. Roma: Armando editore.

[6] Vedere: Reale, Giovanni, Dario Antiseri, 2008. Storia della filosofia – scienza, epistemologia e filosofi americani del XX secolo, 11. Milano: Bompiani.

[7] Leopardi, Giovanni, 1997. Zibaldone, 445. Roma: Newton.

[8] Weil, Simone, 1971. Sulla scienza, 144. Torino: Borla.

[9] Leopardi, Giovanni, 1997. Zibaldone, 642. Roma: Newton.

[10] Jonas, Hans, 1992. Scienza come esperienza personale – autobiografia intellettuale, 10. Brescia: Morcelliana.

[11] Heisenberg, Werner Karl, 1961. Fisica e filosofia, 200. Milano: Il Saggiatore.

[12] Vedere: Colozza, Giovanni Antonio, 1900. L’immaginazione nella scienza – Appunti di Psicologia e Pedagogia. Torino: Paravia; Deregibus, Arturo. 1998. La filosofia di Gaston Bachelard tra scienza e immaginazione. Firenze: Editrice Le Lettere. Nicotra, Luca. 2023. “L’immaginazione nell’arte e nella scienza.” JD. ArteScienza 10 (19). IT: A.P.S. “Arte e Scienza”: 5–38. doi: 10.30449/AS.v10n19.171.; Gallo, Domenico, 2004 (pubblicato il 16 Novembre 2004). L’immaginazione scientifica: https://www.carmillaonline.com/2004/11/16/limmaginazione-scientifica/ (breve articolo divulgativo; ultima visita del sito web: 18/10/2024); Holton, Gerald, 1983. L’immaginazione scientifica. Torino: Einaudi; Holton, Gerald, 1997. La lezione di Einstein. In difesa della scienza. Milano: Feltrinelli.

[13] Andler, Daniel, 2024. Il duplice enigma – Intelligenza artificiale e Intelligenza umana, 232, 236. Torino: Einaudi. Per una bibliografia aggiornata sul tema vedere: Andler, 379-392.

[14] Vedere il recente saggio di Redeker, Robert, 2023. L’abolition de l’ame. Paris: Editions du Cerf.